Главная

Уязвимость в Cursor AI Code Editor

12 сентября 2025 года исследователи Oasis Security сообщили об опасной уязвимости в Cursor — популярном форке Visual Studio Code с интеграцией AI. Проблема кажется мелкой, но последствия могут быть крайне серьёзными: достаточно открыть репозиторий в редакторе, и на компьютере разработчика незаметно выполняется чужой код.

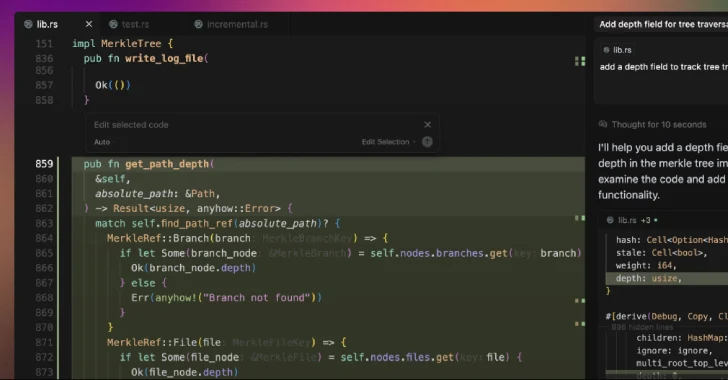

Причина в том, что в Cursor по умолчанию отключена функция Workspace Trust. В оригинальном VS Code она служит барьером безопасности и предотвращает автоматический запуск задач из непроверенных проектов. В Cursor этот механизм оказался выключен, а значит, любой скрипт, прописанный в .vscode/tasks.json, способен стартовать без спроса. Достаточно выставить опцию runOptions.runOn: "folderOpen", чтобы запуск происходил в момент открытия папки.

Таким образом, злоумышленнику нужно лишь разместить на GitHub или другой платформе проект с «подложкой» в конфигурации. Стоит ничего не подозревающему разработчику открыть такую папку в Cursor — и вредоносный код тут же выполнится с его правами доступа.

Последствия очевидны: от кражи токенов и SSH-ключей до внедрения бэкдоров в исходный код и использования машины как точки входа для атак на компанию. Такой сценарий превращает невинный жест «File → Open Folder» в полноценную кибератаку.

Эксперты рекомендуют пользователям Cursor немедленно включить Workspace Trust, избегать открытия незнакомых репозиториев напрямую, проверять содержимое .vscode/tasks.json и по возможности использовать изолированные среды или другие редакторы для анализа чужих проектов.

История с Cursor — лишь часть более масштабной картины. В последние месяцы выявлен целый ряд уязвимостей в AI-IDE и связанных инструментах: от обхода аутентификации в Claude Code (CVE-2025-52882) и SQL-инъекций в Postgres MCP до path traversal в Microsoft NLWeb и критических ошибок авторизации в Lovable (CVE-2025-48757). Добавим сюда XSS и утечки API-ключей в Base44 и Ollama Desktop, и станет ясно: поверхность атаки у таких продуктов стремительно растёт.

Не стоит забывать и о специфических угрозах для AI-инструментов. Prompt injection и jailbreak-атаки позволяют подсовывать моделям скрытые инструкции, заставляя их игнорировать проверки или выполнять вредоносный код в неподходящем окружении. В ряде случаев это может привести даже к утечкам данных из продакшн-систем.

Вывод прост: вместе с удобством и скоростью разработки AI-редакторы приносят новые риски. И дело не только в «экзотических» атаках на нейросети — зачастую виноваты базовые недочёты в настройках безопасности.

Сегодня индустрии нужно отказаться от подхода «сначала функциональность, потом защита». Безопасные конфигурации должны быть включены по умолчанию, а разработчики обязаны вырабатывать привычку проверять код и репозитории, прежде чем доверять им. Иначе одна невинная строка в tasks.json может превратить эксперимент с новым инструментом в серьёзный инцидент для всей компании.

Берегите себя и свои нервы.